FINE-TUNING & OPTIMIZE LLMS

Khóa học Fine-tuning & Optimize LLMs là chương trình đào tạo kỹ thuật chuyên sâu, được thiết kế cho những ai muốn vượt qua giới hạn của việc sử dụng các mô hình có sẵn để tự mình tùy biến, huấn luyện và tạo ra các mô hình ngôn ngữ lớn mang lợi thế cạnh tranh riêng.

Chương trình sẽ tập trung vào hai trụ cột kỹ thuật quan trọng nhất. Đầu tiên là Fine-tuning, bạn sẽ học cách chuẩn bị các bộ dữ liệu chất lượng cao và làm chủ các kỹ thuật tinh chỉnh hiệu quả về mặt tài nguyên (Parameter-Efficient Fine-Tuning – PEFT) như LoRA và QLoRA. Những kỹ thuật này cho phép bạn “dạy” thêm kiến thức và phong cách riêng của doanh nghiệp cho các mô hình mạnh mẽ như Llama hay Mistral, ngay cả khi không có các hệ thống GPU khổng lồ.

Trụ cột thứ hai là Tối ưu hóa Vận hành. Một mô hình tốt là chưa đủ, nó cần phải hoạt động hiệu quả và tiết kiệm chi phí. Bạn sẽ đi sâu vào các kỹ thuật như Quantization và Pruning để giảm đáng kể kích thước mô hình và tăng tốc độ xử lý. Cuối cùng, bạn sẽ học cách đóng gói và triển khai các mô hình đã được tối ưu này dưới dạng một API hiệu năng cao.

Thời lượng: 30h

Hình thức đào tạo:

-

- Đào tạo trực tiếp tại lớp học

- Đào tạo trực tuyến

- Đào tạo hybrid (trực tuyến kết hợp trực tiếp)

- Đào tạo tại văn phòng khách hàng

KẾT QUẢ ĐẠT ĐƯỢC:

- NẮM VỮNG CÁC PHƯƠNG PHÁP FINE-TUNING HIỆN ĐẠI

Hiểu rõ và áp dụng thành thạo các kỹ thuật Full Fine-tuning, PEFT, và đặc biệt là LoRA/QLoRA để tùy biến mô hình. - XÂY DỰNG DATASET CHẤT LƯỢNG CAO

Thành thạo quy trình thu thập, làm sạch và cấu trúc hóa dữ liệu để chuẩn bị cho việc fine-tuning hiệu quả. - LÀM CHỦ KỸ THUẬT TỐI ƯU HÓA MÔ HÌNH

Biết cách áp dụng Quantization, Pruning, Distillation để giảm kích thước mô hình, tăng tốc độ inference và tiết kiệm chi phí vận hành. - TRIỂN KHAI LLMS HIỆU NĂNG CAO

Có khả năng đóng gói mô hình đã fine-tune bằng Docker và triển khai dưới dạng API hiệu năng cao sử dụng các công cụ chuyên dụng. - TẠO RA CÁC MÔ HÌNH AI CÓ LỢI THẾ CẠNH TRANH

Tự tin xây dựng các mô hình chuyên biệt cho các lĩnh vực hẹp (domain-specific), tạo ra giá trị độc quyền cho sản phẩm hoặc doanh nghiệp.

Đối tượng tham gia

Sinh viên ngành CNTT

Có nền tảng Deep Learning vững chắc, muốn thực hiện các dự án đột phá với mô hình ngôn ngữ.

Lập trình viên

Mong muốn nâng cao kỹ năng kỹ thuật và kiểm soát mô hình ngôn ngữ lớn ở mức độ sâu hơn.

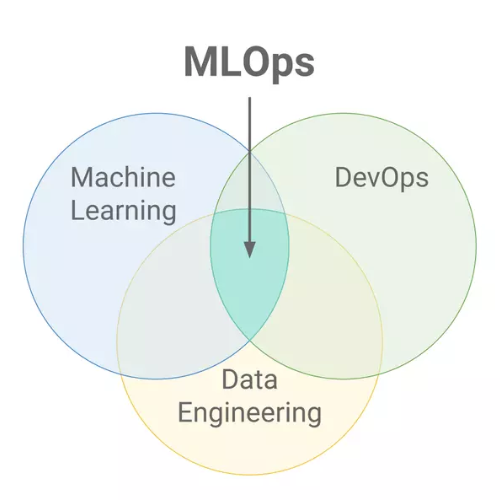

Kỹ sư AI & Machine Learning

Muốn đi sâu vào việc tùy biến và tối ưu hóa các mô hình nền tảng để tạo lợi thế.

Các nhóm R&D doanh nghiệp

Cần kỹ năng để tự xây dựng và huấn luyện các mô hình AI độc quyền cho doanh nghiệp.

Nội dung khóa học

1. Nền tảng và Chiến lược Fine-tuning

-

- Phân tích chiến lược: Khi nào nên dùng Prompt Engineering, RAG, hay Fine-tuning?

- Tổng quan các phương pháp fine-tuning:

- Full Fine-tuning: Ưu/nhược điểm và yêu cầu tài nguyên.

- Parameter-Efficient Fine-Tuning (PEFT): Nguyên lý và lợi ích.

- Chuẩn bị dữ liệu cho fine-tuning:

- Các kỹ thuật thu thập và tạo dataset chất lượng cao.

- Định dạng dữ liệu theo chuẩn instruction-following.

2. Kỹ thuật Fine-tuning Hiệu quả với PEFT

-

- LoRA (Low-Rank Adaptation):

- Hiểu sâu về cơ chế hoạt động và các tham số quan trọng (rank, alpha).

- Thực hành fine-tuning một mô hình mã nguồn mở (Llama 3, Mistral) với LoRA.

- QLoRA: Kỹ thuật kết hợp LoRA và Quantization để fine-tune các mô hình lớn trên GPU phổ thông.

- Đánh giá mô hình sau fine-tuning: Sử dụng các chỉ số và phương pháp đánh giá định tính.

- LoRA (Low-Rank Adaptation):

3. Giới thiệu về RLHF và các phương pháp nâng cao

-

- RLHF (Reinforcement Learning from Human Feedback):

- Hiểu quy trình 3 bước của RLHF để làm cho mô hình an toàn và hữu ích hơn.

- Vai trò của Reward Model và Policy Model.

- Giới thiệu các phương pháp thay thế như DPO (Direct Preference Optimization).

- RLHF (Reinforcement Learning from Human Feedback):

4. Tối ưu hóa Mô hình sau Huấn luyện

-

- Quantization:

- Nguyên lý giảm độ chính xác của trọng số để thu nhỏ mô hình.

- Thực hành các kỹ thuật 8-bit và 4-bit quantization.

- Model Pruning & Distillation: Giới thiệu các kỹ thuật cắt tỉa và chưng cất mô hình để tạo ra các phiên bản nhỏ gọn, hiệu quả hơn.

- Tối ưu hóa Inference: Kỹ thuật Caching và Batching request.

- Quantization:

5. Đóng gói và Triển khai Mô hình

-

- Export mô hình đã fine-tune và tokenizer.

- Xây dựng API hiệu năng cao với FastAPI để phục vụ inference.

- Đóng gói ứng dụng và các file phụ thuộc bằng Docker.

- Giới thiệu và sử dụng các server chuyên dụng cho LLM như vLLM, TGI (Text Generation Inference).

6. BÀI THỰC HÀNH CUỐI KHÓA

-

- Xây dựng và Tối ưu hóa Chatbot Chuyên gia

- Lựa chọn và Chuẩn bị:

- Học viên chọn một lĩnh vực chuyên môn (ví dụ: phân tích báo cáo tài chính, tư vấn luật, marketing).

- Tự thu thập, làm sạch và tạo một bộ dữ liệu nhỏ (~500-1000 mẫu) theo định dạng instruction.

- Huấn luyện và Tối ưu:

- Fine-tune một mô hình mã nguồn mở (ví dụ: Mistral-7B) trên bộ dữ liệu đã tạo bằng kỹ thuật QLoRA.

- Thực hiện Quantization 4-bit cho mô hình sau khi fine-tuning.

- Triển khai và Đánh giá:

- Đóng gói mô hình đã tối ưu và triển khai dưới dạng một API.

- So sánh hiệu năng (tốc độ, chất lượng output) của mô hình đã fine-tune so với mô hình gốc.

- Lựa chọn và Chuẩn bị:

- Xây dựng và Tối ưu hóa Chatbot Chuyên gia

LỊCH KHAI GIẢNG

(Đang cập nhật)

Bài viết liên quan