Xử lý dữ liệu lớn (Big Data)

“Trong bối cảnh dữ liệu được xem là “”dầu mỏ”” của nền kinh tế số, vai trò của Kỹ sư Dữ liệu – những người xây dựng và vận hành các “”nhà máy lọc dầu”” – trở nên quan trọng hơn bao giờ hết. Chuyên đề Big Data được thiết kế như một hệ sinh thái các khóa học chuyên sâu, độc lập, nhằm trang bị cho bạn những kỹ năng và công cụ hiện đại nhất để giải quyết các bài toán dữ liệu ở quy mô lớn.

Thay vì một lộ trình cứng nhắc, chuyên đề này mang đến sự linh hoạt, cho phép bạn lựa chọn chính xác những khóa học mình cần để nâng cao năng lực. Các khóa học được phân chia thành các nhóm kỹ năng thực tiễn, bao quát toàn bộ vòng đời của dữ liệu: Nền tảng Kỹ thuật, Xử lý Dữ liệu Lớn, Công cụ Modern Data Stack, Vận hành & Triển khai.

Dù bạn đang muốn bắt đầu sự nghiệp Kỹ sư Dữ liệu hay đã là một kỹ sư kinh nghiệm cần cập nhật những công nghệ mới nhất, chuyên đề này sẽ cung cấp cho bạn những khóa học cần thiết để xây dựng và quản lý các hệ thống dữ liệu bền vững và hiệu quả.”

Bài viết liên quan

Tiếng anh

chuyên ngành IT

Chương trình tiếng Anh chuyên ngành IT hướng đến nâng cao kỹ năng giao tiếp và đọc hiểu tài liệu chuyên môn, giúp học viên tự tin làm việc trong môi trường quốc tế và phát triển sự nghiệp.

Câu hỏi thường gặp

Chuyên đề hướng đến các Lập trình viên Backend, Kỹ sư DevOps, Data Analyst muốn chuyển sang lĩnh vực kỹ thuật dữ liệu, và sinh viên CNTT có nền tảng lập trình vững chắc.

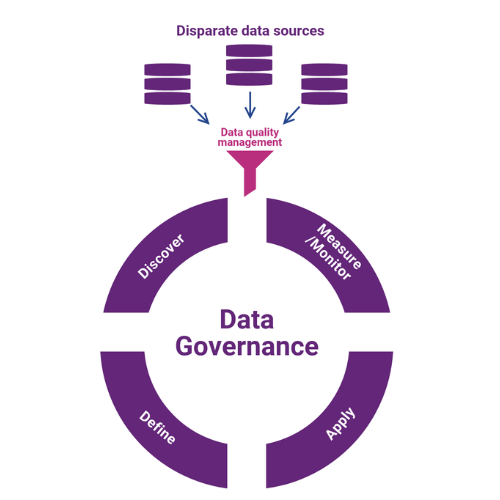

Điểm nổi bật là sự tập trung vào Modern Data Stack. Chuyên đề không dạy các công nghệ cũ mà bao gồm một bộ sưu tập các khóa học về những công cụ và quy trình (DataOps, Data Governance) mà các công ty công nghệ hàng đầu đang sử dụng và tuyển dụng hiện nay.

Có. Các khóa học đều dựa trên dự án. Trong khóa Airflow, bạn sẽ xây dựng các DAG điều phối. Trong khóa Spark, bạn sẽ viết các job xử lý dữ liệu. Trong khóa dbt, bạn sẽ xây dựng các mô hình chuyển đổi. Bạn sẽ học bằng cách xây dựng các thành phần thực tế của một pipeline.

Vì hệ thống dữ liệu hiện đại là một hệ sinh thái chuyên môn hóa. Mỗi công cụ giải quyết một bài toán xuất sắc: Kafka cho luồng dữ liệu thời gian thực, Spark cho xử lý dữ liệu lớn, dbt cho chuyển đổi, và Airflow để “chỉ huy” tất cả. Làm chủ chúng giúp bạn trở thành một kỹ sư đa năng và giá trị.

Không. Mặc dù kiến thức về Toán học luôn hữu ích, nhưng vai trò của Kỹ sư Dữ liệu tập trung nhiều hơn vào kỹ thuật phần mềm, kiến trúc hệ thống, và giải quyết vấn đề về hiệu năng. Chuyên đề này không yêu cầu kiến thức toán cao cấp và phức tạp như trong lĩnh vực Khoa học Dữ liệu.

CẢM NGHĨ CỦA HỌC VIÊN

Từ Thiên Vũ

Thầy cực kiên nhẫn, giải thích từng bước một. Dù mình là newbie vẫn theo kịp được.

Lê Hồng Nguyên Linh

Lab ở đây phải gọi là đỉnh. Dùng tài khoản hãng chính hãng, mọi thứ y như môi trường thực tế. Highly recommend học AWS ở đây nhé.

Trương Tuấn Hoàng

Chương trình đúng kiểu ‘work-ready’, vừa học vừa áp dụng vào công việc. Có thể chọn hình thức học linh hoạt, hôm nào kẹt lịch chuyển online liền, không bị miss buổi nào.

La Thị Minh Tuyết

Anh chị giảng viên rất vui tính, luôn tạo không khí để lớp có thể hoàn thành tốt dự án, hơn hết chúng em cũng được giải đáp thắc mắc và được hỗ trợ một cách kịp thời.

Ngọc Khang Văn

Ngay khi khóa học tôi đã nhận được offer Junior với mức lương ngoài mong đợi. Những kiến thức từ khóa học rất sát với thực tiễn và giúp tôi nhanh chóng thích nghi với công việc từ doanh nghiệp.

Trần Văn Khoa

Chương trình học phù hợp, lộ trình học tập được sắp xếp khoa học. Những kiến thức được truyền tải tại đây có thể áp dụng ngay trong công việc. Giảng viên nhiệt tình, truyền đạt kiến thức tốt.

Nguyễn Minh Thiện

Chương trình học ở đây được biên soạn kỹ càng và dễ hiểu đối với những người chưa có nhiều kinh nghiệm như em. Ngoài việc được đào tạo kiến thức chuyên môn em cũng được các anh chia sẻ khá nhiều về kinh nghiệm thực tế từ trải nghiệm của anh.