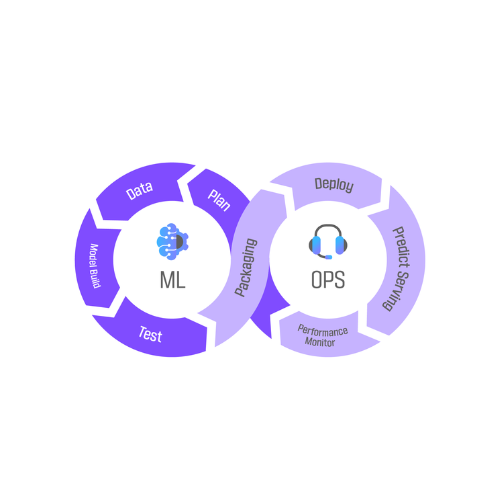

MLOps – Triển khai và Vận hành Mô hình

Một mô hình AI dù mạnh mẽ đến đâu cũng sẽ vô giá trị nếu nó chỉ nằm trong Jupyter Notebook. MLOps chính là cây cầu nối liền giữa nghiên cứu và sản phẩm, là tập hợp các quy trình kỹ thuật chuyên nghiệp để giải quyết “bài toán dặm cuối” (last-mile problem), biến mô hình thành giá trị thực tế cho doanh nghiệp. Khóa học này được thiết kế để trang bị cho bạn bộ kỹ năng không thể thiếu đó, giúp bạn chuyển từ vai trò một nhà khoa học dữ liệu sang một kỹ sư AI toàn diện, có khả năng vận hành hệ thống.

Chương trình sẽ hướng dẫn bạn một cách có hệ thống toàn bộ quy trình triển khai một dự án AI chuyên nghiệp. Bạn sẽ bắt đầu bằng việc học cách đóng gói và quản lý phiên bản mô hình, sau đó xây dựng API inference hiệu suất cao với FastAPI để phục vụ dự đoán. Tiếp theo, bạn sẽ học cách container hóa toàn bộ ứng dụng bằng Docker để đảm bảo tính nhất quán và di động. Bạn cũng sẽ làm chủ MLflow để theo dõi, quản lý vòng đời và đảm bảo tính tái lập của các phiên bản mô hình.

Điểm nhấn của khóa học là việc tự động hóa toàn bộ quy trình bằng CI/CD với GitHub Actions, giúp bạn kiểm thử, xây dựng và triển khai các thay đổi một cách nhanh chóng và an toàn. Toàn bộ kiến thức này sẽ được tổng hợp trong một dự án cuối khóa, nơi bạn sẽ triển khai một ứng dụng AI end-to-end lên nền tảng cloud. Hoàn thành khóa học, bạn sẽ sở hữu những kỹ năng MLOps thực chiến, yếu tố then chốt giúp bạn khác biệt và thăng tiến trong sự nghiệp AI.

Thời lượng: 18h

KẾT QUẢ ĐẠT ĐƯỢC

ĐÓNG GÓI, TRIỂN KHAI MÔ HÌNH AI CHUYÊN NGHIỆP

Xuất mô hình ML/DL, tạo API inference với FastAPI, đóng gói bằng Docker cho môi trường production.

THÀNH THẠO CI/CD CHO DỰ ÁN AI

Xây dựng pipeline kiểm thử, build, deploy tự động với GitHub Actions, quản lý lifecycle model chuyên nghiệp.

QUẢN LÝ, GIÁM SÁT MÔ HÌNH VỚI MLFLOW

Theo dõi, ghi nhận, so sánh các phiên bản mô hình, logging metric/artifact suốt quá trình phát triển.

TRIỂN KHAI ỨNG DỤNG LÊN CLOUD

Tích hợp API, model registry, monitoring, tối ưu hóa vận hành cho doanh nghiệp.

PROJECT THỰC HÀNH TRIỂN KHAI END-TO-END

Được trải nghiệm toàn bộ quy trình từ xuất mô hình, tạo API, deploy lên cloud, quản lý bằng MLflow và tự động hóa với CI/CD.

Yêu cầu tiên quyết:

-

- Thành thạo Python, ML/DL cơ bản (đã làm project với Scikit-learn/PyTorch/TensorFlow)

- Biết sử dụng Git, có khái niệm cơ bản về Docker là một lợi thế

Nội dung khóa học

1. Đóng gói mô hình (Model Packaging)

- Lý do cần đóng gói:

- Phân biệt model file (pickle/joblib) vs code/requirements.

- Tái sử dụng, chia sẻ nội bộ, kiểm soát version và dễ dàng triển khai lại trên môi trường khác.

- Xuất mô hình:

- Scikit-learn: Dùng pickle, joblib để serialize model.

- PyTorch: TorchScript (tracing/scripting) – phục vụ inference nhanh trên server hoặc edge device.

- TensorFlow: SavedModel, TFLite – cho production/mobile.

- ONNX: Chuẩn open để chuyển đổi giữa các framework.

- Tổ chức project AI:

- Folder structure cho production (src, models, api, requirements.txt, Dockerfile…)

- Ghi chú các best practices để project dễ bảo trì, nâng cấp sau này.

2. Xây dựng API cho mô hình với FastAPI

- Giới thiệu FastAPI:

- Ưu điểm cho ứng dụng AI: async, auto-documentation, type hints.

- So sánh Flask, FastAPI và các web framework khác.

- Thiết kế endpoint API:

- Định nghĩa endpoint /predict, nhận input JSON (dữ liệu khách hàng, hình ảnh…).

- Validate input với Pydantic.

- Gọi mô hình đã export để trả về output dự đoán dạng JSON.

- Xử lý error, logging, trả về response chuẩn hóa.

- Tích hợp mô hình vào API:

- Tải model vào RAM khi start server, inference trực tiếp trong endpoint.

- Tối ưu tốc độ và bảo vệ API khi chạy production (caching, batch prediction, limit requests).

3. Containerization với Docker

- Tổng quan Docker cho AI:

- Ưu điểm: Tính nhất quán môi trường, dễ scale, dễ deploy từ local lên cloud.

- Khái niệm image, container, registry.

- Viết Dockerfile cho ứng dụng AI:

- Cài đặt Python, dependencies, copy code/model vào image.

- Expose cổng cho FastAPI, tối ưu layer Docker để build nhanh và nhẹ.

- Docker Compose:

- Quản lý nhiều service cùng lúc: API, database, Redis, MLflow server…

- Định nghĩa volumes để lưu trữ model/log data.

4. Theo dõi mô hình với MLflow

- Giới thiệu MLflow:

- Giải quyết vấn đề tracking thí nghiệm, metrics, model registry cho team AI.

- Thành phần chính: Tracking, Projects, Model Registry, Model Deployment.

- Tích hợp MLflow vào project:

- Log thông số (parameters), kết quả (metrics) khi train model.

- Log artifacts (file model, hình ảnh, báo cáo…).

- Lưu trữ nhiều version mô hình – so sánh, phục hồi lại nhanh chóng khi cần.

- Register model vào MLflow Model Registry để quản lý lifecycle.

5. CI/CD cơ bản cho mô hình AI

- Khái niệm CI/CD cho AI:

- Vì sao AI cần CI/CD? Tăng tốc phát triển, giảm lỗi thủ công, kiểm soát chất lượng.

- Workflow phổ biến: Test → Build → Deploy tự động.

- GitHub Actions:

- Giới thiệu file workflow YAML, trigger (push/pull request), jobs/steps.

- Thiết lập các bước tự động:

- Lint/check code, test API.

- Build Docker image khi code thay đổi.

- Push image lên Docker Hub.

- Deploy lên server staging/production (tuỳ môi trường).

- Kiểm thử tự động:

- Viết unit test cho API, integration test end-to-end.

- Đảm bảo model cũ vẫn hoạt động khi nâng cấp version mới (backward compatibility).

6. BÀI THỰC HÀNH CUỐI KHÓA: Triển khai AI End-to-End

- Yêu cầu tổng hợp:

- Tích hợp toàn bộ quy trình:

- Export model từ code training.

- Build API bằng FastAPI, đóng gói Docker, lưu trữ model artifacts.

- Tracking các thí nghiệm, version model bằng MLflow.

- Thiết lập pipeline CI/CD (GitHub Actions) để tự động kiểm thử, build, deploy lên cloud.

- Deploy ứng dụng lên AWS/GCP/Render, đảm bảo API inference chạy ổn định trên cloud.

- Output:

- API inference chạy online (có thể gọi thử với dữ liệu mẫu, check response).

- MLflow tracking các version model, truy xuất lại nhanh.

- CI/CD pipeline tự động – mỗi lần update code, model sẽ tự động build và deploy lại lên production (hoặc staging).

- Tích hợp toàn bộ quy trình:

Bài viết liên quan